Últimamente han surgido algunos debates sobre qué errores estándar deberían utilizar los profesionales en presencia de heteroscedasticidad en modelos lineales. La discusión me intrigó, así que eché un segundo vistazo a la literatura existente. Presento una visión general de la investigación teórica y de simulación que nos ayuda a responder a esta pregunta. También presento resultados de simulación que imitan o amplían algunos de los estudios de simulación existentes. Voy a compartir el código de Stata que utilicé para las simulaciones con la esperanza de que pueda ser útil para aquellos que quieran explorar cómo los diversos estimadores de error estándar se desempeñan en situaciones que son relevantes para su investigación.

De mis ejercicios de simulación, concluyo que ninguna matriz de varianza-covarianza de estimadores (VCE) es preferible a otras en todas las combinaciones posibles de diferentes tamaños de muestra y grados de heteroscedasticidad. Por ejemplo, si ampliamos el diseño de simulación de MacKinnon (2012) para incluir covariables discretas, la tasa de rechazo del 5% para los coeficientes de las covariables discretas en algunos casos es mejor cuando utilizamos el VCE Huber/White/sandwich proporcionado por la opción vce(robust) de Stata. Para las covariables continuas, las conclusiones son diferentes.

De la literatura surgen dos consideraciones prácticas. En primer lugar, tomar el tamaño de la muestra por sí solo como criterio no es suficiente para obtener errores estándar precisos en presencia de heteroscedasticidad. Lo que importa es el número de observaciones por regresor. Si tiene 250 observaciones y 4 regresores, el rendimiento de los estimadores de errores estándar coherentes con la heteroscedasticidad probablemente será bueno. Si tiene 250 observaciones y 10 regresores, puede que esto ya no sea cierto. Del mismo modo, tener 10.000 observaciones puede no ser suficiente si tiene 500 regresores. A medida que aumenta el número de parámetros, también lo hace la información necesaria para estimarlos de forma coherente. Además, a medida que se reduce el número de observaciones por regresor, todos los errores estándar actuales coherentes con la heteroscedasticidad se vuelven inexactos, como analizan Cattaneo, Jansson y Newey (2018).

En segundo lugar, los puntos de apalancamiento muy por encima de la media importan. Los puntos de apalancamiento son funciones de las covariables que miden cuánta influencia tiene una observación en el ajuste por mínimos cuadrados ordinarios. Los puntos de apalancamiento están entre 0 y 1. Un punto de apalancamiento de 1 ejerce apalancamiento en el sentido de que la orientación de la línea de regresión en la dirección de la covariable está totalmente determinada por las covariables. El residuo estimado para un punto con apalancamiento de 1 es 0. Las pruebas de simulación muestran que el rendimiento de los errores estándar coherentes con la heteroscedasticidad mejora cuando los puntos de alto apalancamiento no están presentes en un diseño, como se discute en Chesher y Austin (1991).

Estas dos consideraciones están relacionadas. La media de los puntos de apalancamiento es igual al número de regresores dividido por el número de observaciones (la inversa del número de observaciones por regresor). Para un número fijo de regresores, a medida que aumenta el tamaño de la muestra, disminuyen la media del apalancamiento y la probabilidad de tener puntos de apalancamiento con valores grandes. Por tanto, tener suficientes observaciones por regresor reduce los problemas asociados a los puntos de apalancamiento altos.

En resumen, cuando pensamos en errores estándar robustos, la métrica relevante es el número de observaciones por regresor. Si el número de observaciones por regresor es pequeño, independientemente del tamaño de la muestra, nuestra inferencia puede ser imprecisa, incluso cuando utilizamos errores estándar coherentes con la heteroscedasticidad que corrigen el sesgo. No existe una solución milagrosa que permita realizar inferencias fiables si no se dispone de datos suficientes para cada parámetro que se desee estimar.

Historia e intuición

Cuando pensamos en errores estándar consistentes con la heteroscedasticidad en modelos lineales, pensamos en White (1980). El resultado clave del trabajo de White es que podemos obtener una estimación consistente del VCE incluso si no podemos obtener una estimación consistente de algunos de sus componentes individuales. Esta fue una idea innovadora y condujo a otros desarrollos importantes en la estimación de errores estándar, como menciona MacKinnon (2012).

Los resultados de White, sin embargo, son asintóticos. Son apropiados cuando se tiene un tamaño de muestra grande bajo ciertas condiciones de regularidad. No hay nada benigno en la frase "bajo ciertas condiciones de regularidad". Aquí es donde las cosas se complican y donde tenemos que explorar qué es lo que hay que satisfacer para confiar en las herramientas que estamos utilizando.

El estimador de White tiene sesgo. Como muchos resultados asintóticos, el sesgo disminuye a medida que aumenta el número de observaciones. MacKinnon y White (1985) proponen tres estimadores asintóticamente equivalentes para abordar el sesgo de muestra pequeña de los errores estándar consistentes en la heteroscedasticidad de White.

La intuición detrás de los estimadores es que los residuos de mínimos cuadrados tienden a subestimar los verdaderos errores. Todas las soluciones propuestas abordan este problema aumentando el peso de las estimaciones individuales de la varianza. El primero de estos estimadores, HC1, es un ajuste de grados de libertad del orden n/(n-k), donde n es el tamaño de la muestra y k es el número de regresores. Esto se obtiene en Stata cuando se utiliza vce(robust). Los otros dos estimadores son HC2 (vce(hc2)), que corrige el sesgo en la varianza del residuo que surge bajo homoscedasticidad, y HC3 (vce(hc3)), un estimador jackknife. MacKinnon y White (1985) descubren que, para tamaños de muestra pequeños, HC2 y HC3 funcionan mejor que HC1 en sus simulaciones y que HC3 es la alternativa preferida.

HC2 y HC3 son funciones de hii, los elementos diagonales de la matriz X(X′X)−1X′

Los hii también se denominan puntos de apalancamiento. Un hii alto, en relación con la media de los hii, ejerce más palanca en la dirección del plano de regresión. Los puntos con un apalancamiento de 1, por ejemplo, se encuentran en la línea de regresión. HC2 y HC3 dan mayor peso a los residuos de las observaciones con mayor apalancamiento.

Chesher y Jewitt (1987) y Chesher y Austin (1991) estudian el sesgo de los estimadores propuestos por MacKinnon y White (1985). La forma explícita del sesgo es una función de hii. Uno de los resultados interesantes de Chesher y Austin (1991) es que las simulaciones de MacKinnon y White (1985) "contienen un punto de apalancamiento moderado" que, una vez eliminado, hace que "todas las pruebas que utilizan estimadores de matrices de covarianza coherentes con la heteroscedasticidad funcionen bien".

Long y Erwin (2000) dan consejos sobre el uso de errores estándar coherentes con la heteroscedasticidad. Al igual que MacKinnon y White (1985), consideran que HC3 funciona mejor en muestras pequeñas. También sugieren que los diferentes estimadores VCE estudiados en MacKinnon y White (1985) empiezan a ser equivalentes después de 250 observaciones. Esta conclusión es coherente en todos sus diseños de simulación. El número 250 no es aleatorio. Sus diseños tienen cinco regresores. Después de 250 observaciones, hay más de 50 observaciones por regresor. Esta es una consideración importante. Con 10 regresores y heteroscedasticidad, 250 observaciones podrían no ser suficientes.

Los resultados teóricos y de simulación de Cattaneo, Jansson y Newey (2018) ilustran la importancia de tener suficientes observaciones para cada regresor. Examinan la relación asintótica de k/n. Aunque sus resultados son para un marco diferente, muestran que el rendimiento de todos los estimadores discutidos anteriormente es pobre cuando n/k es pequeño.

Los resultados de Long y Erwin (2000) y Cattaneo, Jansson y Newey (2018) están estrechamente relacionados con los de MacKinnon y White (1985), Chesher y Jewitt (1987) y Chesher y Austin (1991). Están relacionados a través de hii. La media de hii es k/n. Así, la media de los puntos de apalancamiento es también una forma de ver cuánta información necesitamos para recuperar cada uno de los k parámetros de nuestra especificación.

Resultados de la simulación

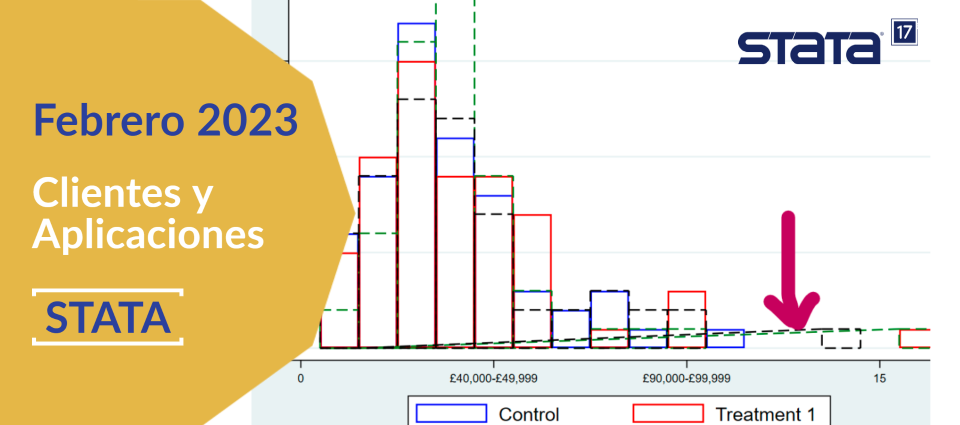

A continuación, presento tres conjuntos de resultados de simulaciones. El primero sigue el espíritu de MacKinnon (2012). El segundo sigue el espíritu de Long y Erwin (2000). El tercero sigue a Angrist y Pischke (2009). En las simulaciones, comparo HC1, HC2, HC3 y el bootstrap salvaje (WB). El WB en las simulaciones impone la hipótesis nula, es para 999 réplicas, y utiliza pesos de Rademacher.

Las simulaciones de MacKinnon (2012) examinan el rendimiento de los errores estándar coherentes con la heteroscedasticidad en la clase HCk (HC1, HC2 y HC3) y en el WB. Considera un término de error, εi, de la forma

εi=(∑i=1kXikβk)γN(0,1)

Un valor de γ=0 implica ausencia de heteroscedasticidad, y un valor de γ≥1 implica alta heteroscedasticidad. Las covariables no están correlacionadas y tienen una distribución logarítmica normal. Las simulaciones a continuación a las que me refiero como simulaciones tipo MacKinnon siguen la misma estructura, pero también incorporan covariables discretas.

Long y Erwin (2000) crean la varianza multiplicando el término de error también por una función de covariables. Sin embargo, permiten que las covariables estén correlacionadas e incluyen covariables discretas. Además, la distribución de todas las covariables difiere. Para algunos diseños, los términos de error se extraen de una distribución normal y para otros de una distribución χ2. Las simulaciones a continuación que yo llamo simulaciones tipo Long y Erwin siguen la idea de correlacionar las covariables, utilizando términos de error de una distribución χ2, y teniendo covariables continuas y discretas de diferentes distribuciones. Sin embargo, a diferencia de Long y Erwin (2000), incluyo todas las covariables en la expresión que multiplica el término de error.

Las simulaciones de Angrist y Pischke (2009) son para una sola variable binaria. Introducen heteroscedasticidad, permitiendo que la varianza cambie dependiendo del valor de la covariable. Además, la proporción de ceros y unos está sesgada. Sigo el mismo diseño, pero exploro el comportamiento para diferentes tamaños de muestra y no para un tamaño de muestra de 30, como Angrist y Pischke (2009).

La razón por la que elegí estos tres conjuntos de simulaciones es intentar abarcar los resultados más representativos y conocidos de la literatura. Los amplío para incorporar características que quería considerar, como covariables discretas y una forma de heteroscedasticidad que incorpora todas las covariables. Las modificaciones son menores, pero proporcionan una intuición que no era inmediata a partir de las especificaciones originales.

Ir al artículo original

Más información sobre este producto:

Entre en contacto con:

Joel Cervantes

Ejecutivo Software Diverso

jcervantes@multion.com

+52 (55) 55594050 Ext.119

WhatsApp:

+52 (55) 3465 5373